“AI” onder de loep

Lees het oorspronkelijk artikel in het Engels hier.

In een vorig artikel wierpen we een kritische blik op "Artificiële Intelligentie". Voor deze blog gaan we dieper in op toepassingen van deep learning in specifieke domeinen, om te zien hoe neurale netwerken van belang kunnen zijn voor de maatschappij in het algemeen, maar ook specifiek voor de kunstpraktijk.

Natural Language Processing

Natural language processing is een van de meest ongrijpbare gebieden in de computerwetenschap. Computers zijn goed met getallen, minder met woorden. Bedrijven als Google investeren miljarden in dit onderzoek, bijvoorbeeld om het makkelijker te maken dingen op te zoeken in de digitale wereld of, vervelender, om klantenservices te automatiseren.

Vroege pogingen met chatbots - computerprogramma’s die gesprekken kunnen voeren - dateren al uit de jaren zestig, met de beroemde virtuele psychotherapeute ELIZA. In de jaren negentig werd de eerste versie van ALICE gecreëerd. Deze chatbots vertellen misschien meer over onszelf dan over computers. In typische sessies zijn gebruikers in eerste instantie verbaasd over de uncanny menselijke gelijkenis, gevolgd door een natuurlijke drang om de interactie te verbreken. Daardoor komen de beperkingen van de implementatie vrij gemakkelijk aan het licht.

De explosie aan deep learning-toepassingen bracht in 2019 GPT-2 voort. Hoewel zeer overtuigend voor een paar zinnen, wordt de tekst onbegrijpelijker naarmate hij langer wordt. GPT-2 is getraind op een enorme set teksten die van het web zijn gehaald. Het is precies de omvang van de dataset en de complexiteit van het model waardoor vooruitgang werd boekt. De opvolger GPT-3 werd in 2020 gedemonstreerd en is een grote stap voorwaarts, in de eerste plaats opnieuw door de grotere dataset. 31 OpenAI-onderzoekers uitten hun bezorgdheid over een mogelijk gevaar voor de mensheid. Op zijn minst gezegd is dat een slimme marketingzet.

In zekere zin kunnen we AI-tekstgeneratie in dezelfde categorieën plaatsen als orakels, waarzeggerij en écriture automatique. Door het programma te stimuleren met onze input, krijgen we een antwoord dat kan fascineren en inspireren.

Laat ons hiervoor GPT-2 gebruiken, dat is leuker dan GPT-3, in de zin dat we GPT-2 zelf kunnen trainen met extra data. We hebben onze bot gecoacht op Becketts Wachten op Godot, drie keer opnieuw, elke iteratie 200 leercycli. De Godot-heid neemt toe met elke iteratie, maar ga te ver en de data zal overfit geraken. Dan wordt met letterlijke passages uit Wachten op Godot geantwoord.

Godot 1

Mens: Gaan computers ons vervangen?

AI: Nee, dat is niet hun ding. Maar er wordt hen een vraag gesteld. Een vraag die gesteld wordt. Een vraag die ieder mens kwaad zou moeten maken.

Godot 2

Mens: Wat zal de toekomst brengen? We hebben het verleden nog maar net overleefd.

AI: Des te erger voor mij. Wat hebben we precies gedood? Wat hebben we gedaan? Wat is er met het team gebeurd? Wat hebben we gedaan? Wat hebben we precies gedood? Ik weet het niet meer. Wat hebben we gedaan? Wat heb ik je nooit verteld? Vraag me dat niet. Er is een reden waarom we nooit met elkaar gesproken hebben. Weet je zeker dat dit voorbij is? Oh, zeg ik. Ik denk het niet.

Godot 3

Mens: Waarom zijn we zo bang voor AI?

AI: Omdat het denkt? Omdat het hersenen heeft? Heeft het dat? Nee. Het is net als wij. Het denkt. Doet het dat? Nee. Het denkt niet. Het heeft gedachten. Heeft het dat? Nee. Het zijn helemaal geen gedachten. Het zijn gevoelens. Ik weet het niet.

De valkuilen van GPT zijn loops en herhalingen. Toevallig werkt dit goed met Wachten op Godot, want ook de oorspronkelijke tekst heeft een neiging tot horten en stoten, dramatisch en oratorisch.

Deze passages zijn gegenereerd uit een kleinere versie van GPT, een voorbeeld van een tekst gegenereerd met een grotere dataset, over de gevaren van AI, vind je hier.

Generative adversarial networks

Generative adversarial networks of GAN's zijn een meer fundamentele vooruitgang in de computerwetenschap. Eenvoudig gezegd zijn het twee neurale netwerken die met elkaar wedijveren om elkaar voor de gek te houden. Ze blinken uit in het genereren van bijvoorbeeld portretten, die volkomen kunstmatig zijn, maar er voor ons vrij overtuigend menselijk uitzien, ook al worden ze snel uncanny als ze langere tijd worden geobserveerd.

Een tool die dit implementeert is InterfaceGAN, waarmee we het beeld kunnen veranderen op basis van parameters als leeftijd en geslacht.

Het potentieel voor gebruik in deepfakes en manipulatie is duidelijk.

Bij CREW besteden we veel tijd aan het digitaliseren van ruimtes en mensen met scanners en fotogrammetrie. Het digitaliseren van mensen is niet eenvoudig omdat ze vaak microbewegingen maken, zoals ademhalen. De industriestandaard is om gesynchroniseerde foto's te nemen met een 50-tal digitale camera's.

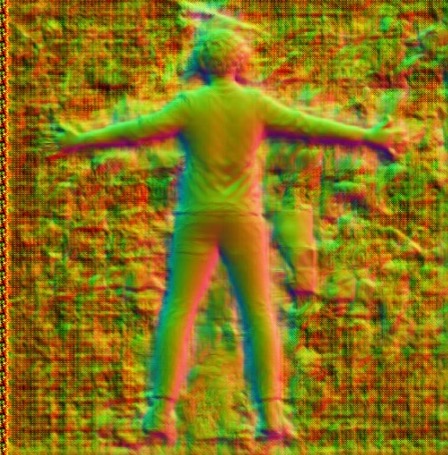

Met de bibliotheek PIFUHD kan één enkele frontale foto een volledig 3D model genereren. Het algoritme kan daadwerkelijk, en vrij nauwkeurig, voorspellen hoe u er van achteren uitziet.

De afbeelding hierboven is een dieptebeeld, maar we kunnen ook een 3D model genereren. Dit kan op zijn beurt een basis zijn voor het genereren van gestileerde avatars die nog steeds gelijkenis vertonen met de persoon in de afbeelding en die de verhoudingen hebben van een echt mens. De "modderfiguren" in Delirious Departures zijn hier een voorbeeld van, we hebben scans gebastraheerd tot ze een sculpturale kwliteit krijgen.

Enigszins teleurstellend is dat het algoritme niet werkt met alleen de foto van een gezicht. Dat is het soort conceptuele sprong die het idee van de intelligente machine doorbreekt: het kan een probleem oplossen, maar alleen dat probleem. Het kan deze kennis niet toepassen op een ander gebied.

Deep Learning in PRESENT

In het kader van ons EU-onderzoeksprogramma PRESENT hebben onderzoekers van de Universiteit van Augsburg een systeem ontwikkeld om emoties in spraak te detecteren. Omdat ze niet tevreden waren met de resultaten, voegden ze een gezichtscamera toe aan de invoer, waardoor het foutenpercentage drastisch daalde.

Om het netwerk te trainen, werden video's van sprekende mensen met ondertitels geanalyseerd. De tekstuele inhoud van de ondertitels werd gerelateerd aan de gezichtsuitdrukkingen. Het neurale netwerk werd hierop getraind. Voeg enkele stappen toe, en het resultaat is een vrij nauwkeurige analyse van emotie via gezichtsuitdrukkingen en spraakintonatie.

We gebruiken dit in een van onze meer toegepaste projecten. Kinderen met autisme moeten leren om emoties waar te nemen, te integreren en uit te drukken via gezichtsuitdrukking. Gewoonlijk doen ze oefeningen met een spiegel. Wij willen iets leukers en interactievers voorstellen, waarbij ze een minigame aangaan met een ultrarealistische avatar en moeten proberen een emotie na te bootsen of te spiegelen.

Maar...

De valkuil is echter dat wij de AI-modellen over het algemeen als black boxes gebruiken. Dat wil zeggen dat we ze gebruiken als een set instrumenten, ontwikkeld met onze partners of door externe partijen. We zouden er graag meer zelf ontwikkelen, maar het probleem is dat het maken van een dataset en een bruikbaar algoritme duur en arbeidsintensief is. In de praktijk zijn er een aantal openbare datasets die veel worden hergebruikt.

Dit belang van data en rekenkracht, dat in de aard van deep learning zit, heeft een aantal zeer concrete gevolgen voor de samenleving. Onderzoekers zijn gebonden aan zeer strikte procedures, terwijl multinationale ondernemingen de hele tijd uw gegevens oogsten. Sceptisch blijven over de beweringen rond AI en op je hoede zijn voor het afstaan van controle aan algoritmen, is een slimme houding. Maar, de urgentere kwestie is de combinatie het eigendom van gegevens en de beschikbare rekenkracht en de ongelijkheid de daaruit voortvloeit.

Alle valkuilen terzijde, deep learning is een tastbare innovatie. Het is leuk en inspirerend en het kan vervelende taken gemakkelijker maken. Dat is de sterkte van deap learning: het bevindt zich ergens tussen menselijk denken en de mechanistische instructies die we machines geven. Als een prosthetisch glijmiddel, verwijdert machine learning een deel van de frictie die bestaat in de interactie tussen mens en machine.

Isjtar